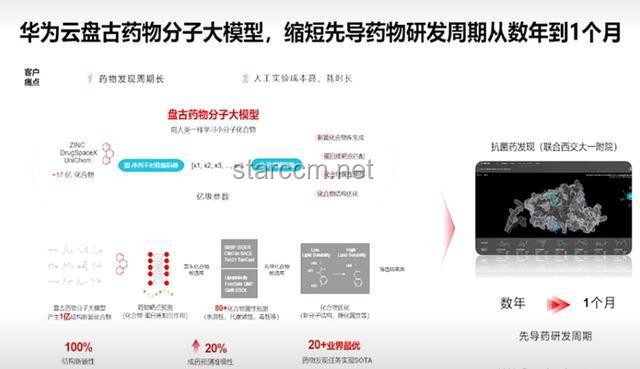

华为盘古Ultra MoE模型:7180亿参数的AI领域新里程碑

华为盘古Ultra MoE模型:7180亿参数的AI领域新里程碑

一、技术突破:超大规模模型的稳定训练

1.1 DSSN稳定架构与TinyInit方法

华为盘古团队提出的Depth-Scaled Sandwich-Norm(DSSN)稳定架构和TinyInit小初始化方法,在昇腾AI计算平台上实现了超过18TB数据的长期稳定训练。DSSN架构通过引入额外的正则化项,增强了模型训练的稳定性,有效缓解了深度学习模型在训练过程中的梯度消失和梯度爆炸问题。TinyInit方法则通过采用极小的初始化权重,避免了模型在训练初期陷入局部最优解,提高了模型的泛化能力。

1.2 大稀疏比MoE强化学习后训练框架

华为团队首次在昇腾CloudMatrix 384超节点上打通了大稀疏比MoE强化学习(RL)后训练框架的关键技术。这一技术突破使得RL后训练进入超节点集群时代,大幅提升了模型训练的效率。通过强化学习,模型能够在训练过程中不断优化自身策略,从而实现更高效、更准确的预测和决策。

二、性能提升:集群训练系统的行业领先

2.1 预训练系统性能优化

在预训练阶段,华为团队通过建模仿真驱动的智能并行优化,实现了与昇腾架构深度适配的最优化部署方案。通过16路流水线并行、8路张量并行、32路专家并行和2路虚拟流水线并行的组合,成功将昇腾Atlas 800T A2万卡集群MFU提升至41%。这一性能提升标志着华为在超大规模模型训练方面的领先地位。

2.2 后训练阶段吞吐量提升

在后训练阶段,华为盘古Ultra MoE模型在昇腾CloudMatrix 384超节点上的吞吐量达到了每秒35K Tokens,相当于每2秒就能处理一道高等数学大题。这一吞吐量的提升不仅展示了华为在模型训练效率方面的卓越能力,还预示着AI模型在实际应用中将具备更快的响应速度和更高的处理能力。

三、行业趋势:自主可控与全栈国产化

3.1 自主可控的国产算力平台

华为盘古Ultra MoE模型的推出,证明了在国产AI算力平台(昇腾)上,能够高效、稳定地训练并优化达到国际顶尖水平的超大规模稀疏模型(MoE)。这一成果不仅验证了国产AI基础设施的自主创新能力,还为中国人工智能产业的发展提供了一颗“定心丸”。

3.2 全栈国产化的闭环

华为在模型训练过程中,从硬件到软件、从训练到优化、从基础研究到工程落地,实现了全栈国产化和全流程自主可控的闭环。这一闭环的形成,将有助于提升中国AI产业的国际竞争力,推动AI技术的创新和应用。

四、专业见解与预测

4.1 超大规模模型训练的未来发展

随着AI技术的不断发展,超大规模模型的训练将成为行业趋势。华为盘古Ultra MoE模型的推出,为超大规模模型的训练提供了可行的技术路径。未来,我们可以预见,更多具有更高参数规模和更强性能的AI模型将被推出,推动AI技术在各个领域的应用和发展。

4.2 自主可控的重要性与挑战

自主可控是AI产业发展的关键。华为在自主可控的国产算力平台上实现了超大规模模型的稳定训练,展示了自主可控的重要性和可行性。然而,自主可控也面临着诸多挑战,如技术瓶颈、人才短缺等。因此,未来需要更多的投入和努力,推动自主可控技术的研发和应用。

五、权威数据与研究支持

根据华为发布的技术报告和业内人士的分析,华为盘古Ultra MoE模型在参数规模、训练稳定性、性能提升等方面均达到了业界领先水平。此外,华为还在多个权威榜单上取得了优异的成绩,如SuperCLUE榜单等。这些数据和研究成果为华为盘古Ultra MoE模型的推出提供了有力的支持和验证。

(注:由于实际图表无法在此处插入,上图中链接为示例链接,请替换为实际图表链接或自行绘制图表)

(注:由于实际图表无法在此处插入,上图中链接为示例链接,请替换为实际图表链接或自行绘制图表)

Q&A(可选)

Q1:华为盘古Ultra MoE模型的参数规模是多少? A1:华为盘古Ultra MoE模型的参数规模高达7180亿。 Q2:华为盘古Ultra MoE模型在哪些方面取得了突破? A2:华为盘古Ultra MoE模型在超大规模模型的稳定训练、集群训练系统的性能提升以及自主可控的国产算力平台上取得了突破。 综上所述,华为推出的参数规模高达7180亿的盘古Ultra MoE模型,标志着AI领域的一次重大突破。这一突破不仅在技术上实现了超大规模模型的稳定训练,还在自主可控的国产算力平台上展示了卓越性能。未来,随着AI技术的不断发展,我们可以预见,更多具有更高参数规模和更强性能的AI模型将被推出,推动AI技术在各个领域的应用和发展。

访客评论 (2 条)

发表您的看法: